3.5 Daten- und Algorithmenethik

Grundbegriffe Datenethik

Testen Sie hier Ihre Vorkenntnisse über Grundbegriffe zur Datenethik.

Quelle: Bendel, O. (2021). 300 Keywords Soziale Robotik. Springer Books.

Ethikquiz: Wer soll entscheiden? Wem vertrauen Sie? Mensch oder Maschine?

(Kurs: KI und Ethik III: Künstliche Intelligenz und Ethik – Grundlagen, Kapitel 3.1, 2. Reflexion)

Begriff: Daten- und Algorithmenethik

Sehen Sie sich das nachfolgende Video an.

(Kurs: Daten- und Algorithmenethik, Episode 2, Erklärvideo für den Begriff „Daten- und Algorithmenethik“)

Mini-Quiz: Daten- und Algorithmenethik

(Kurs: Daten- und Algorithmenethik, Episode 2, Mini-Quiz: Daten- und Algorithmenethik)

Probleme von Daten

Video: Qualitäten von Daten

Sehen Sie sich das folgende Video bis Minute 4:30 an.

(Kurs: KI und Ethik III: Künstliche Intelligenz und Ethik – Grundlagen, Kapitel 2.3, 2. Qualitäten von Daten)

Anwendungsaufgabe:

(Kurs: KI und Ethik III: Künstliche Intelligenz und Ethik – Grundlagen, Kapitel 2.3, 4. Anwendung)

Moralität und Entscheidungen

Interaktives Video: Moral und Algorithmen

Sehen Sie sich das folgende Video ab Minute 5:45 an.

(Kurs: Daten- und Algorithmenethik, Episode 3, Interaktives Video: Moral und Algorithmen)

Interview mit Prof. Dr. Joanna Bryson über Moral und Algorithmen

Sehen Sie sich das folgende Interview an.

(Kurs: Daten- und Algorithmenethik, Episode 3, Interview mit Prof. Dr. Joanna Bryson über Moral und Algorithmen)

Quiz: Moralität

Soziotechnische Systeme

Sehen Sie sich das folgende Video ab Minute 1:33 an.

(Kurs: KI und Ethik III: Künstliche Intelligenz und Ethik – Grundlagen, Kapitel 3.2, 2. Ethische Erwägungen: Herausforderungen)

Verständnisübung: Vergleich technische – soziotechnische Systeme

(Kurs: KI und Ethik III: Künstliche Intelligenz und Ethik – Grundlagen, Kapitel 3.2, 4. Verständnis)

Reflektion der Einstiegsübung:

Haben Sie Ihre Meinung geändert? Wer soll die Entscheidungen treffen? Mensch oder Maschine?

Fallbeispiel: Automatisiertes Bewerbermanagement

Beantworten Sie die Fragen als Basis für die synchrone Vorlesung.

Künstliche Intelligenz, so die Meinung vieler Techno-Utopisten, kann eine gerechtere Welt schaffen, weil ihre Entscheidungsprozesse frei von Emotionen und damit auch von Vorurteilen sind. Das klingt zwar gut, sieht in der Praxis allerdings häufig anders aus. Ein gutes Beispiel dafür ist Amazon. Nach einem Reuters-Bericht versucht das Unternehmen schon seit 2014, eine KI zu entwickeln, die den Einstellungsprozess optimieren sollte. „Sie wollten eine Maschine, der du 100 Bewerbungen gibst und die dann die besten fünf Kandidaten ausspuckt“, zitiert Reuters einen anonymen Amazon-Mitarbeiter. Ein Jahr später haben die Verantwortlichen dann aber einen folgenschweren Fehler bemerkt: Die KI benachteiligte Frauen. Das Problem lag hier wie so häufig bei den Trainingsdaten, anhand derer die KI lernen sollte, welche Bewerber Amazon gerne einstellen würde. Die KI-Modelle wurden anhand von Bewerbungen trainiert, die innerhalb der letzten zehn Jahre bei Amazon eingegangen waren. Die meisten davon kamen allerdings von Männern. Ein offensichtliches Muster, aus dem das System folgerte, dass Männer die bevorzugten Kandidaten waren.

https://t3n.de/news/diskriminierung-deshalb-platzte-amazons-traum-vom-ki-gestuetzten-recruiting-1117076/

Aufgabenstellung:

Nehmen Sie jeweilis die Perspektive bzw. Rolle des Unternehmens, des/r Programmier*in und des/r Anwender*in ein:

- Schreiben Sie für jede Rolle jeweils zwei Pro- und Contra-Argumente für ein automatisiertes Bewerbermanagement auf.

- Welche Motive könnten dahinter liegen, warum solche Entscheidungen an Algorithmen delegiert werden? Formulieren Sie für jede Rolle jeweils zwei Motive.

- Welche positiven und negativen Konsequenzen können sich daraus ergeben und wer trägt hierfür die Verantwortung?

Fallbeispiel: Justizsystem

Lesen Sie den Auszug aus dem Buch „Ein Algorithmus hat kein Taktgefühl“ von Katharina Zweig als Basis für die synchrone Vorlesung und bilden Sie sich eine Meinung.

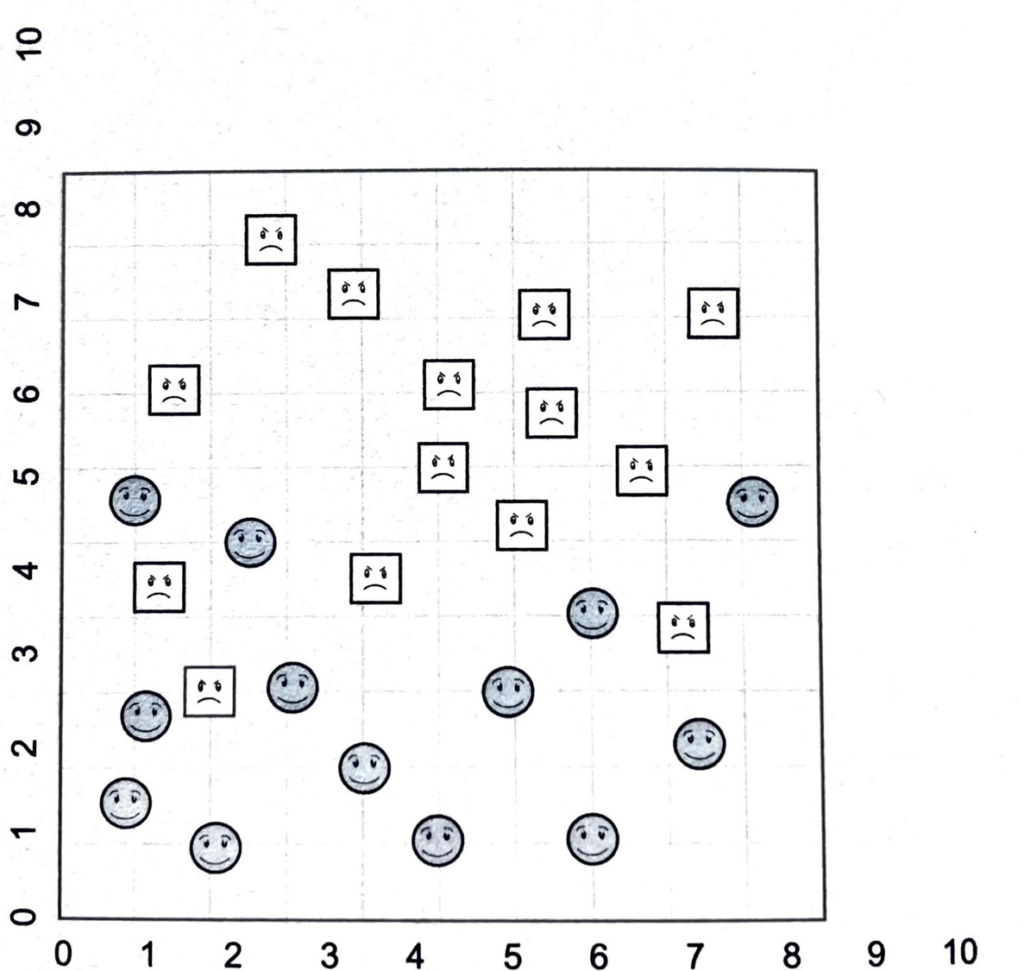

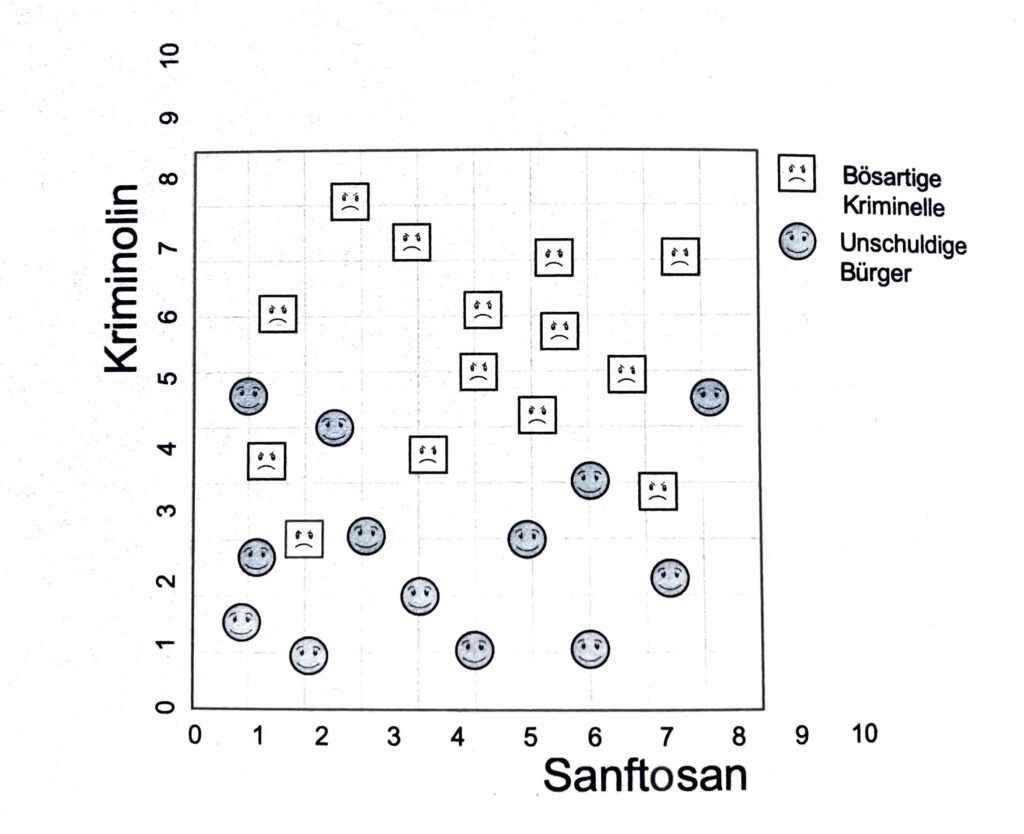

Als Grundlage ist es wichtig, die Theorie der sogenannten Support Vector Maschine zu verstehen. Bei dem Training dieser Maschine muss entschieden werden, auf welche Weise die Daten zwei verschiedenen Gruppen zugeordnet werden. Dabei muss in der unten stehenden Abbildung entschieden werden, wie eine gerade Linie gezogen werden soll, um die quadratischen und die kreisförmigen Smileys möglichst gut voneinander zu trennen. Die Anzahl von Fehlern soll möglichst gering sein.

Stellen Sie sich vor, wir könnten angeblich anhand zweier Hormone im Blut einigermaßen vorhersagen, ob jemand kriminell wird oder nicht. Das eine Hormon heißt dabei „Kriminolin“, da andere „Sanftosan“. Die quadratischen Smileys sind heir hell und stellen männliche und weibliche Kriminelle dar, die kreisförmige grauen Smileys sind unschuldige Bürger:innen. Hier ist die Datenlage: Legen Sie wieder Ihre Trennlinie durch die Datenpunkte, die dann im nächsten Schritt für die Einordnung weiterer Personen genutzt werden soll […].

Tatsächlich geht es hier um eine schwierige Güterabwägung: Auf der einen Seite hat die Gesellschaft ein berechtigtes Interesse daran, möglichst alle Kriminellen zu identifizieren. Aber natürlich sollen Unschuldige geschützt werden. Schon 1760 prägte der Rechtsphilosoph William Blackstone daher die folgende Maxime: „Es ist besser, dass zehn Schuldige entkommen, als dass eine unschuldige Person leidet.“92 Dick Cheney, Ex-Vizepräsident der USA, äußerte dagegen in einem Interview zum Folterreport der CIA über die Verhältnisse in Guantanamo Bay und anderen Lagen im Jahr 2014 einmal die folgende Meinung: „Ich bin besorgter über die Schurken, die gegangen sind und entlassen wurden, als über die paar, die in Wirklichkeit unschuldig waren.“ Der Reporter Chuck Todd hakte nach, ob das auch angesichts der geschätzten 25 Prozent an Unschuldigen gelten würde, die illegal inhaftiert gewesen seien. „solange wir damit unsere Ziele erreichen, habe ich damit kein Problem“93, lautete Cheneys Replik. Die moralische Grundlage der Optimierungsfunktion würde die beiden also sehr unterschiedliche Entscheidungen treffen lassen: Blackstone würde die Linie so einzeichnen, dass kein Unschuldiger auf der falschen Seite landet und Cheney so, dass wirklich alle Kriminellen gefangen werden.94

Das Beispiel zeigt, dass die Wahl des Qualitätsmaßes immer auch eine moralische Abwägung enthält, nämlich die Frage, welche Fehlentscheidung schwerer wiegt. Es ist auch gar nicht möglich, keine Entscheidung darüber zu treffen. Die oben erwähnte Akkuratheit bestimmt beispielsweise implizit, dass die Fehler gleich schlimm sind: Sie zählt die richtigen Entscheidungen und gewichtet dabei nicht, ob eine Person korrekt als Krimineller bezeichnet wurde oder korrekt als unschuldiger Bürger. Beide richtigen Entscheidungen sind gleich viel wert. Wie man an Blackstone und Cheney sieht, kann man das ändern, indem man Gewichte einführt, aber wer genau soll die wie bestimmen? Hier haben wir also ein weiteres Rädchen, eine neue Skala, die immer ethischer Natur ist und die nie „neutral“ oder „objektiv“ ist. Die Frage ist nur: Gewichten Sie eher so wie Blackstone? Oder so wie Cheney? Sie haben die Wahl!

Quelle: Zweig, Katharina (2019): Ein Algorithmus hat kein Taktgefühl. Wo künstliche Intelligenz sich irrt, warum uns das betrifft und was wir dagegen tun können, 5. Auflage, Wilhelm Heyne Verlag, München, S. 164 f.

92 William Blackstone: Commentaries on the Laws of England, Band IV, 1765, 21. Auflage, Weet, Maxwell, Stevens, & Norton, London (1844), S. 358

93 Transkript eines Interviews von Chuck Todd (NBC) mit Dick Cheney und anderen Politikern. Transkript der Sendung „Meet the Press“ vom 14. Dezember 2014, abrufbar unter: https://www.nbcnews.com/meet-the-press/meet-press-transcript-december-14-2014-n268181

94 Die Idee, diese beiden Zitate einander gegenüberzustellen, stammt aus einem sehenswerten Video von Cris Moore über den begrenzten Nutzen von Computern in Wissenschaft und Gesellschaft, abrufbar unter: https://youtube.com/watch?v=Sg2jtEY6qms

Zusammenfassung: 6 Arten von ethischen Bedenken

Sehen Sie sich die Übung an, um das Zusammengefasste zu wiederholen.

(Kurs: KI und Ethik III: Künstliche Intelligenz und Ethik – Grundlagen, Kapitel 3.4, 2. Systematik nach Mittelstadt et al. (2016))